新学期伊始,CVPR2018网站公布了论文录用结果,实验室今年有4篇论文被接收,主题涵盖人脸检测、领域自适应、年龄估计、物体检测等方向。CVPR是由IEEE主办的计算机视觉、模式识别和人工智能领域国际顶级会议,2018年6月将在美国盐湖城召开。

4篇论文的信息概要介绍如下:

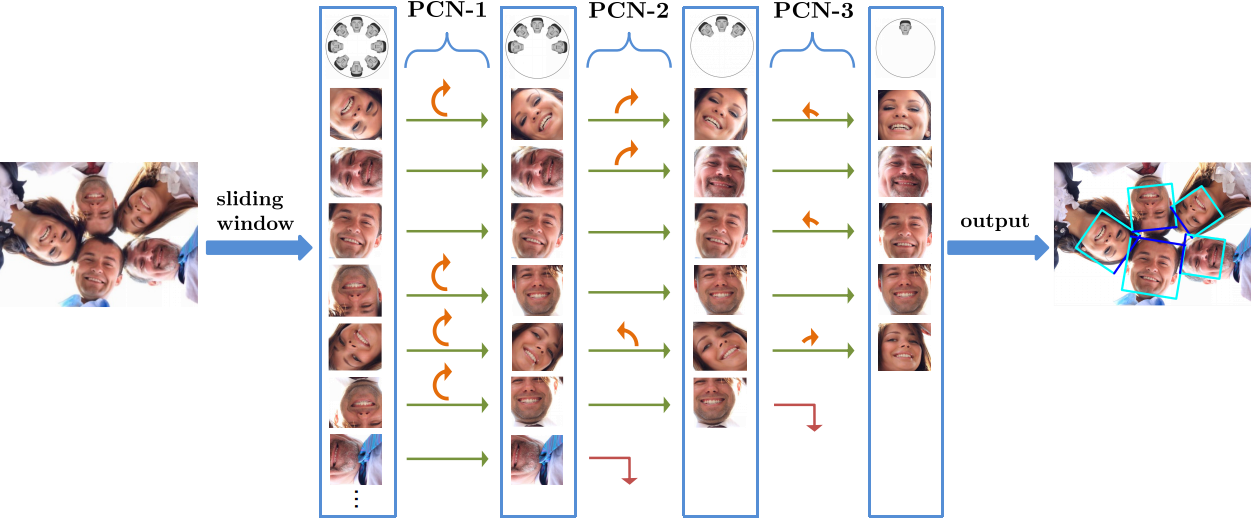

1. Real-Time Rotation-Invariant Face Detection with Progressive Calibration Networks ( Xuepeng Shi, Shiguang Shan, Meina Kan, Shuzhe Wu, Xilin Chen )

在体育直播、家庭合影等真实复杂的场景中,由于人体姿态和取景角度的影响,人脸可能具有任意的平面内旋转角度,这为人脸检测带来了极大的挑战。为解决360°平面内旋转的人脸检测这一挑战性问题,我们提出一种基于级联矫正网络的方法,每级网络同时进行非人脸窗口的过滤和人脸旋转朝向的校正,且前几级网络只进行粗略的朝向分类,以保证校正的精度与速度。逐渐校正减少人脸表观变化的方式显著提高了检测精度。该方法速度快、模型小、精度高,具有良好的应用前景。

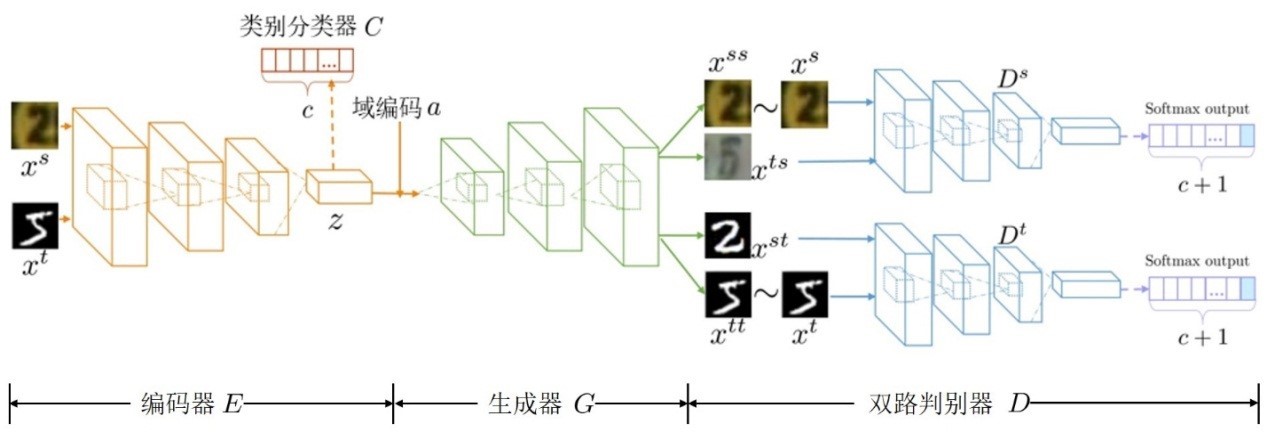

2. Duplex Generative Adversarial Network for Unsupervised Domain Adaptation ( Lanqing Hu, Meina Kan, Shiguang Shan, Xilin Chen )

针对无监督领域自适应问题,我们提出了一种双流对抗生成网络的方法DupGAN。该方法采用生成对抗网络(GAN)的方式将大量带标注样本的知识(称为源域)迁移到一个有着相同目标任务却无标注的样本集合(称为目标域)上。具体地,DupGAN用一个编码器提取特征,一个生成器根据域编码将编码器得到的特征解码为源域或目标域风格的图像,两个判别器与生成器对抗训练并约束样本的具体类别,从而使编码器学到特征为领域无关并带有类别信息的,实现在领域自适应相关测试集上目前最好的性能。

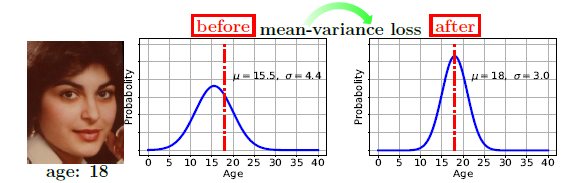

3. Mean-variance Loss for Deep Age Estimation from A Face (Hongyu Pan, Hu Han, Shiguang Shan, Xilin Chen )

标签分布学习是序数型属性学习中一种有效的标签表示方法,其将序数型属性表示为属性标签空间的概率分布(如高斯分布)而非单一取值。传统的基于标签分布学习的属性估计依赖于人工提供或假设标签分布的均值与方差,适用范围有限。我们提出了一种新的损失函数(均值-方差损失,mean-variance loss)用于基于分布学习的年龄估计,将所估计的属性标签分布的均值和方差统一纳入损失计算过程,使得所估计的年龄分布的均值更接近真实年龄值,年龄分布的方差则尽可能的小(而非要求与训练集数据的方差接近)。所提出的方法不需要人为提供或假设训练集数据的标签分布,因此可以推广到更广的序数型属性学习场景。在当前主流的年龄估计数据库(MORPH、FG-NET和CLAP2016)上的实验表明,所提出的年龄估计方法远优于当前最好的方法。此外,我们还将该方法应用于图片美学评价的问题中,在利用较少信息的情况下,取得了与目前最好的方法相近的性能。

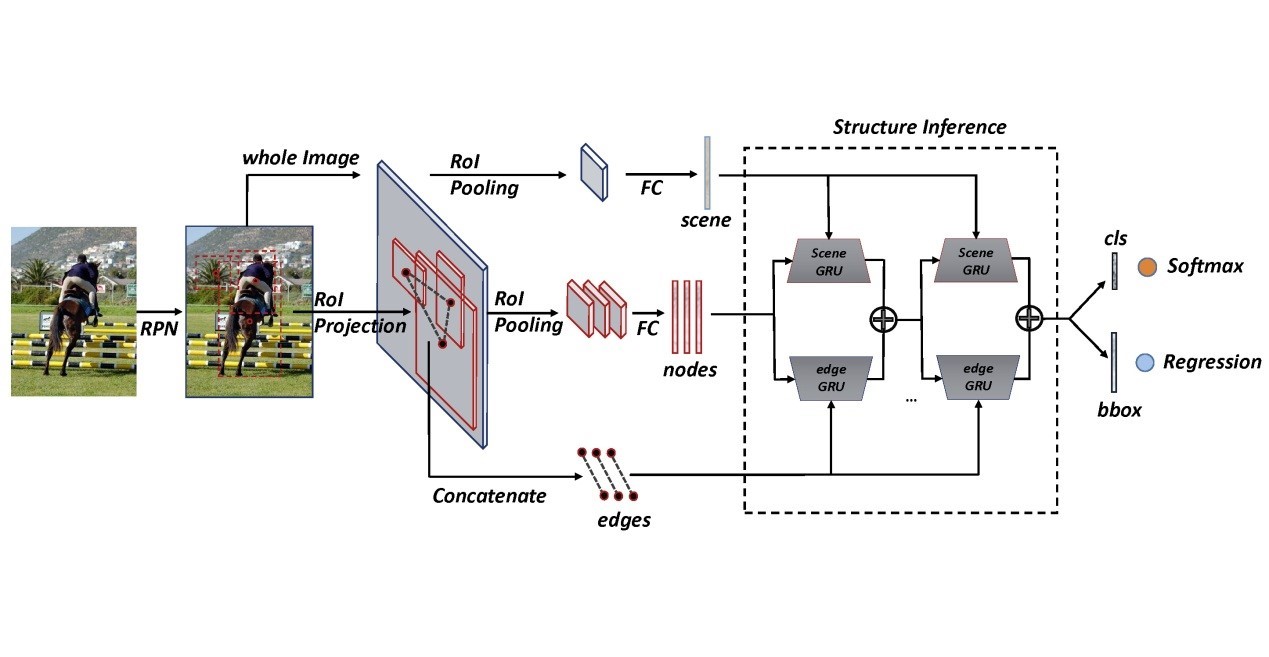

4. Structure Inference Net: Object Detection Using Scene-Level Context and Instance-Level Relationships ( Yong Liu, Ruiping Wang, Shiguang Shan, Xilin Chen )

场景上下文对于精准的物体检测十分重要,在早期研究中多有探索。近年来随着Faster RCNN等深度学习方法的兴起,在日益强调数据和性能的背景下,对上下文关联信息的利用鲜有尝试。本文提出一种结构推理网络(Structure Inference Net,简称SIN),将物体检测问题形式化为图结构推理,采用图结构同时建模物体细节特征、场景上下文、以及物体之间关系,采用门控循环单元(GRU)的消息传递机制对图像中物体的类别和位置进行联合推理。在基准数据集PASCAL VOC和MS COCO上的实验验证了方法在精度提升方面的有效性,同时证实了上下文信息对于输出更为符合人类感知的检测结果确有帮助。

附件: