2023年1月21日,实验室4篇论文被ICLR 2023接收。ICLR会议的全称是International Conference on Learning Representations,是机器学习领域新兴的旗舰国际会议。会议将于2023年5月1日至5日在卢旺达首都基加利召开。

被录用论文的简要介绍如下:

1. Revisiting Graph Adversarial Attack and Defense From a Data Distribution Perspective (Kuan Li, Yang Liu, Xiang Ao, and Qing He)

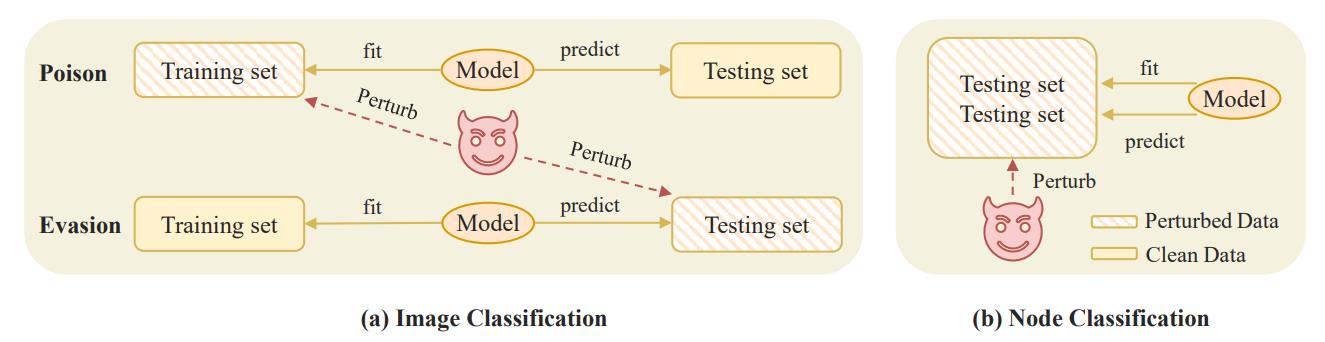

简介:近年研究发现,图神经网络对图结构对抗攻击极其脆弱,只需要非常微小地篡改图结构,就可以大大降低模型性能。虽然已经涌现了大量的攻击、防御算法,但对攻击算法有效性来源的研究较少。在这篇工作中,作者发现攻击算法生成的边并不是均匀分布在图中,而是集中在训练节点周围。这一区别对待训练节点和测试节点的现象启发了作者从关注训练分布和测试分布差异,即分布漂移(distribution shift)的角度来探究图鲁棒性。从这个角度,作者形式化定义了图对抗攻击场景下的分布漂移,并依靠该定义从理论和实验层面分析解释了干扰边非均匀分布等之前难以解释的一些现象,从归纳式学习(inductive learning)和直推式学习(transductive learning)的设定出发分析了图对抗攻击和图像对抗攻击的异同。基于这些分析和定义,作者从投毒攻击、逃逸攻击、防御和数据四个角度提出了9个tips用于提升和改进现有攻击、防御算法,并用实验证明了其有效性。此外,还设计了两个直观的启发式攻击、防御算法,能够在大大减小计算消耗的前提下达到甚至超过现有SOTA模型的效果。

图1 图像分类和节点分类模型对抗攻击范式的差异

2. Hidden Markov Transformer for Simultaneous Machine Translation (Shaolei Zhang, Yang Feng)

简介: 同步机器翻译(Simultaneous Machine Translation,SiMT)在接收源序列的同时输出目标序列,因此学习何时开始翻译每个目标词是同步机器翻译的核心挑战。然而,在许多可能的开始翻译时刻中学习最佳时刻并非易事,因为开始翻译的时刻总是隐藏在模型内部,我们只能用观察到的目标序列来监督SiMT模型。在本文中,我们提出了隐马尔可夫Transformer (Hidden Markov Transformer, HMT),它将开始翻译的时刻视为隐藏事件,将目标序列视为相应的观察事件,从而将两者组织为隐马尔可夫模型。 HMT对多个可能的开始翻译时刻进行显式建模,用作候选隐藏事件,然后选择一个生成目标词。在训练期间,通过在多个开始翻译时刻上最大化目标序列的边际似然,HMT学会在可以更准确地生成目标标记的时刻开始翻译。多个SiMT 基准上的的实验表明,HMT优于强大的基线并实现了最先进的性能。

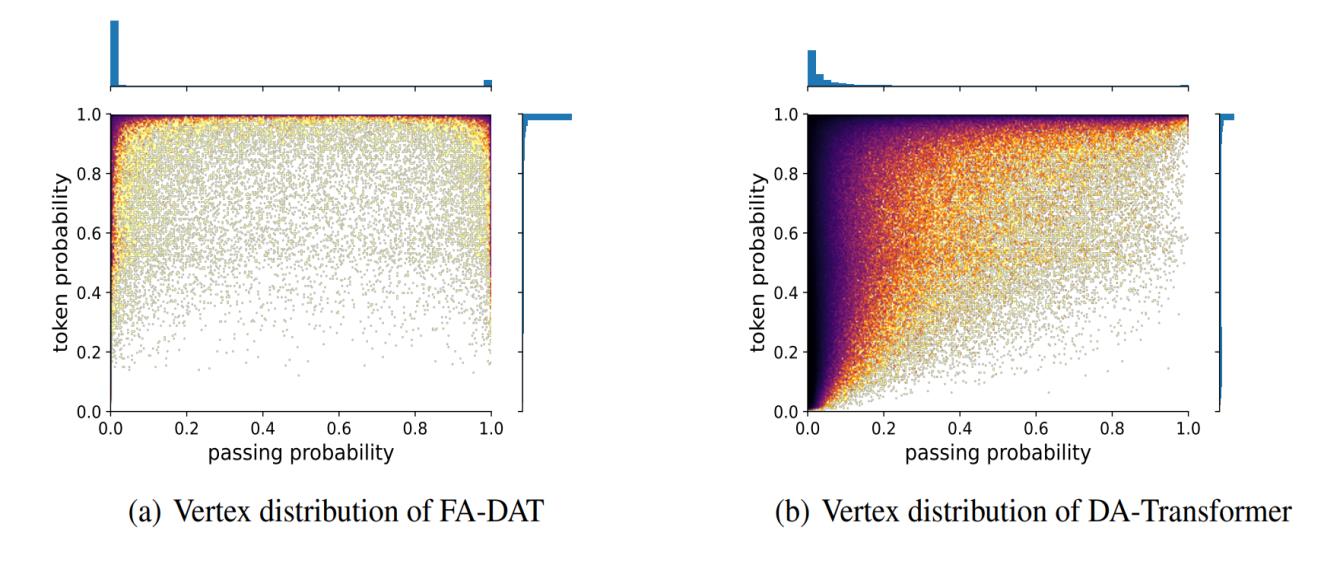

3. Fuzzy Alignments in Directed Acyclic Graph for Non-autoregressive Machine Translation (Zhengrui Ma, Chenze Shao, Shangtong Gui, Min Zhang, Yang Feng)

简介:非自回归机器翻译(Non-autoregressive Translation, NAT)显著降低了用户等待译文的延迟,但因为语言映射的多峰分布特性,往往性能较差。为此,一些研究者尝试将有向无环图(Directed Acyclic Graph, DAG)结构引入NAT系统,试图通过DAG建模输出字词之间的依赖来缓解多峰分布问题。这种系统一般通过极大似然估计的方式进行模型参数学习,以负对数似然(Negative Log Likelihood, NLL)作为损失函数。尽管上述方法取得了一定的成功,我们发现NLL隐式地要求了目标译文字词与DAG节点之间存在严格对齐关系,弱化了DAG学习多峰分布的能力。在本文中,我们考虑DAG中所有可能的路径与参考译文之间均存在某种模糊对齐关系。我们设计了一个模糊对齐指标以衡量图与译文的匹配程度,并以最大化该指标的方式进行参数学习。大量实验表明我们的方法显著地改善了NAT系统的翻译质量,在多个基于原始语料的NAT翻译任务上达到了最先进的性能。

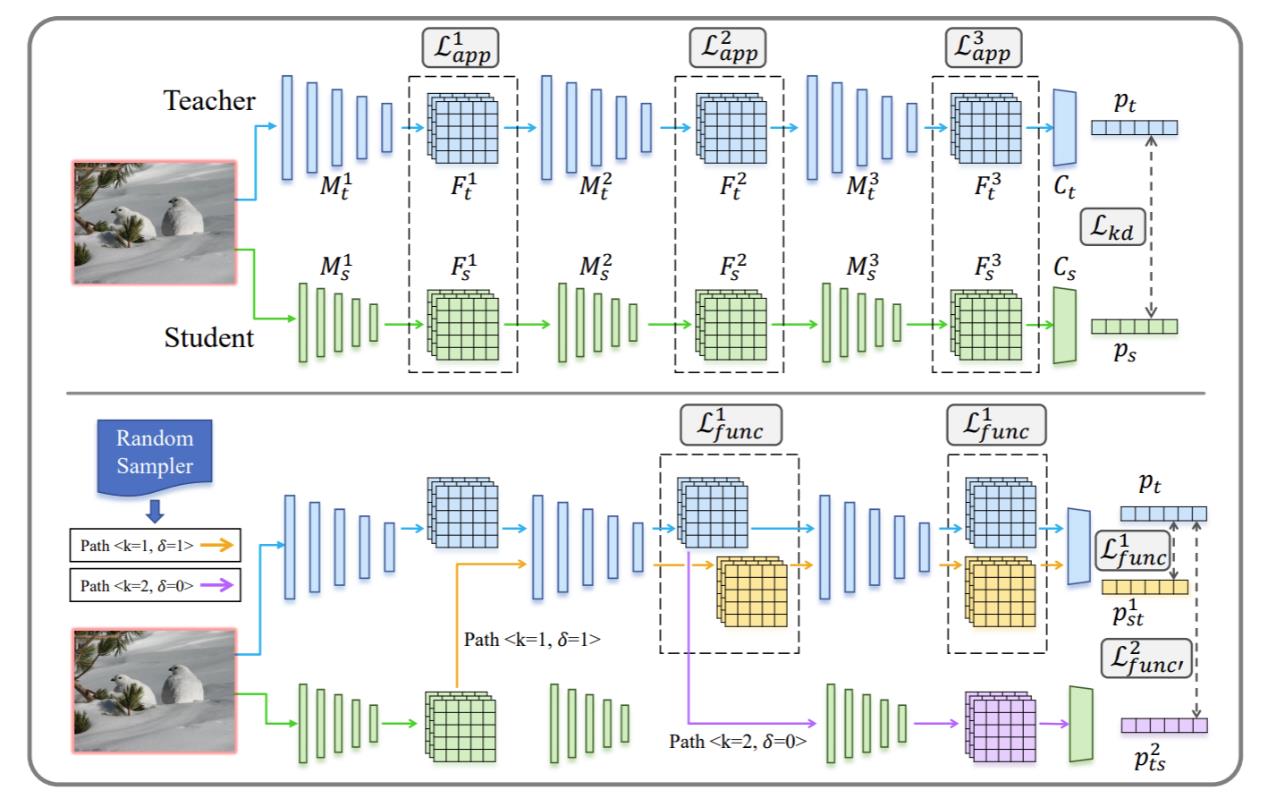

4. Function-Consistent Feature Distillation (Dongyang Liu, Meina Kan, Shiguang Shan, Xilin Chen)

简介:知识蒸馏(Knowledge Distillation,KD)是模型压缩领域的一种常用技术,其通过在小体量模型的训练过程中引入来自大体量模型的监督,达到提升小体量模型精度的目的。特征蒸馏作为知识蒸馏的一种,通过对齐学生模型和教师模型的中间表示实现知识传递。现有的特征蒸馏方法通常使用L2、Smooth L1等距离函数度量学生和教师模型中间表征的相似性。在本文中,我们提出这类距离函数存在重要缺陷:其以各向同性的方式度量特征之间的距离,而神经网络对于中间特征的运用却是各项异性的。换言之,将中间特征朝不同方向改变相同的L2距离,网络最终输出结果的对应差异可能具有完全不同的量级。为了克服上述问题,本文提出功能一致的特征蒸馏,其强调学生模型的特征应当在功能意义下与教师模型的中间特征对齐,即两个特征进入同一个网络的后半部分后,网络的最终输出应该是相似的。通过这种方式,学生模型可以更关注教师特征中那些重要而敏感的方向,并因此更倾向于理解而非简单地记忆教师特征。在图像分类和目标检测任务上的大量实验表明,相较于现有工作,我们的方法显著提升了小体量模型的精度。

附件: