2022年11月,实验室2篇论文被AAAI 2023接收。AAAI 2023的全称是Thirty-Seventh AAAI Conference on Artificial Intelligence,由人工智能促进协会AAAI组织,每年举办一次,为人工智能领域的顶级会议之一。AAAI 2023将于2023年2月7日-2月14日在美国华盛顿举行。

被录用论文的简要介绍如下:

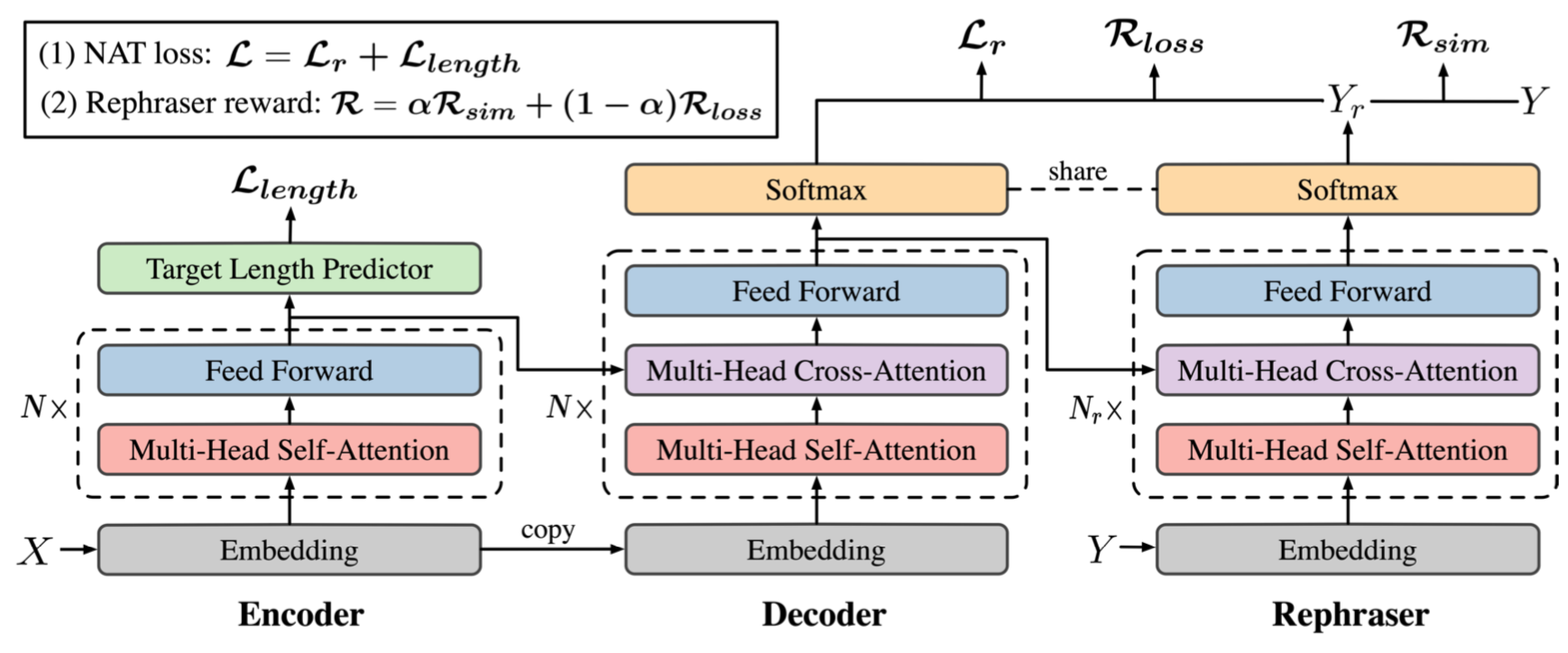

1. Rephrasing the Reference for Non-Autoregressive Machine Translation (Chenze Shao, Jinchao Zhang, Jie Zhou, Yang Feng) - AAAI Main Conference, long paper

简介:非自回归神经机器翻译模型能够并行生成所有单词,显著提高了机器翻译模型的解码速度。限制这类模型性能的主要挑战为多峰性问题,即对同一原文可能存在多种正确的译文。因此,模型的输出方式不一定与参考译文一致,此时使用参考译文训练模型就不再准确。本文引入了一种改写器结构来解决这个问题,改写器直接根据模型的输出改写参考译文,用改写后的结果训练模型。我们希望改写器的输出应与非自回归模型的输出相匹配,但也不应偏离参考译文的语义,这些要求可以被量化为奖赏函数,因此我们可以通过强化学习方法优化改写器。在主流的WMT翻译数据集上和非自回归基线模型上,我们的方法均能稳定地提升非自回归模型的性能,最好的模型能达到与自回归模型相似的性能水平,并且仍保持着14.7倍于自回归模型的解码效率。

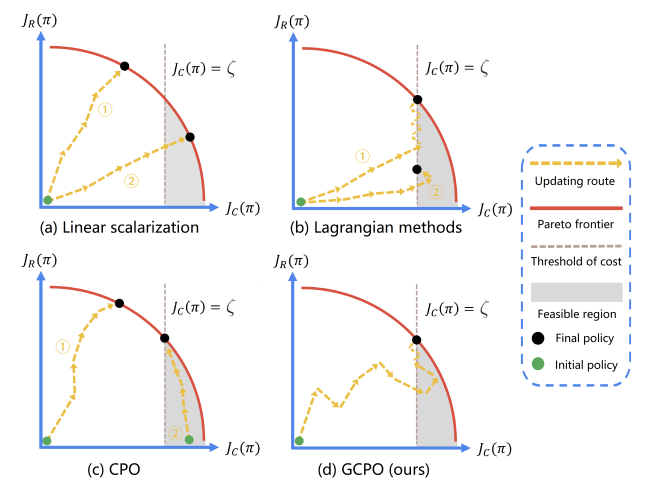

2. Gradient-Adaptive Pareto Optimization for Constrained Reinforcement Learning (Zixian Zhou, Mengda Huang, Feiyang Pan, Jia He, Xiang Ao, Dandan Tu, Qing He) - AAAI Main Conference, long paper

简介:受约束的强化学习(CRL)近年来引起了广泛的兴趣,其目标是在限制成本的同时追求最大化的长期回报。虽然CRL可以视为一个多目标优化问题,但它仍然面临着一个关键的挑战,即基于梯度的帕累托优化方法即使在收益不佳时也倾向于坚持已知的帕累托最优解决方案(例如,从不移动的最安全的自动驾驶汽车)或者直接违反安全约束条件(例如,造成事故的破纪录赛车手)。本文提出了梯度自适应的约束策略优化(简称GCPO),这是一种崭新的具有两种自适应梯度再校准技术的CRL帕累托优化方法。首先,为了找到在所有目标上具有平衡性能的帕累托最优解决方案,提出了梯度再平衡技术,迫使智能体在每次策略迭代中改进未充分优化的目标。其次,为了保证满足成本的约束,提出了暂时牺牲奖励来换取更低成本的梯度扰动技术。在SafetyGym环境下的实验表明,GCPO在满足约束条件的同时,在奖励方面始终优于现有的CRL方法。

附件: