2022年4月,自然语言处理团队1篇论文被NAACL 2022主会录用。 NAACL 2022的全称是2022 Annual Conference of the North American Chapter of the Association for Computational Linguistics - Human Language Technologies (NAACL-HLT 2022),是 ACL 的北美分会,自然语言处理领域的顶级会议之一。NAACL 2022将于2022年7月10日-15日在美国西雅图召开。

被录用论文简介如下:

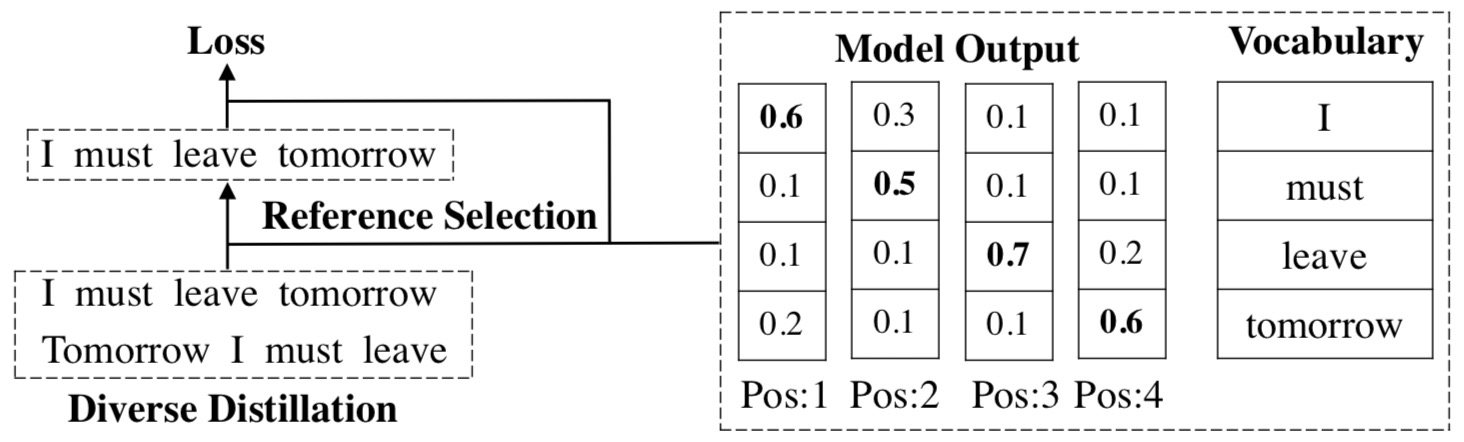

1. One Reference Is Not Enough: Diverse Distillation with Reference Selection for Non-Autoregressive Translation (Chenze Shao, Xuanfu Wu, Yang Feng).Accepted by NAACL 2022 Main Conference.

简介:非自回归机器翻译模型存在多峰性问题:同一个源句可能有多个正确的译文,但模型只根据参考译文计算损失函数。对此,一种解决方案是序列级知识蒸馏,它通过将参考译文替换为自回归模型的输出,使目标端的译文更具确定性。然而,蒸馏后的数据集仍存在一定程度的多峰性,另外,向特定的自回归教师模型学习会限制模型能力的上限,从而约束了非自回归模型的潜力。在本文中,我们认为非自回归模型需要更多的参考译文来训练,并对此提出了多样蒸馏和译文选择的方法。具体地,我们首先通过不同随机种子训练多个教师模型,进行多样化的知识蒸馏,生成一个包含多个高质量参考译文的数据集。在训练非自回归模型时,我们将模型的输出与所有参考译文做比较,选择最匹配模型输出的一个译文来训练模型。实验结果表明,我们的方法在多个数据集上均取得了显著的提升,达到了目前非自回归模型中最先进的性能。

附件: