实验室VIPL组今年有3篇论文被ACM MM 2022接收,ACM MM的全称是ACM International Conference on Multimedia (国际多媒体会议) ,是多媒体领域的国际顶级会议,2022年10月将在葡萄牙里斯本召开。3篇论文的信息概要介绍如下:

1. Zero-shot Video Classification with Appropriate Web and Task Knowledge Transfer (Junbao Zhuo, Yan Zhu, Shuhao Cui, Shuhui Wang, Bin MA, Qingming Huang, Xiaoming Wei, Xiaolin Wei)

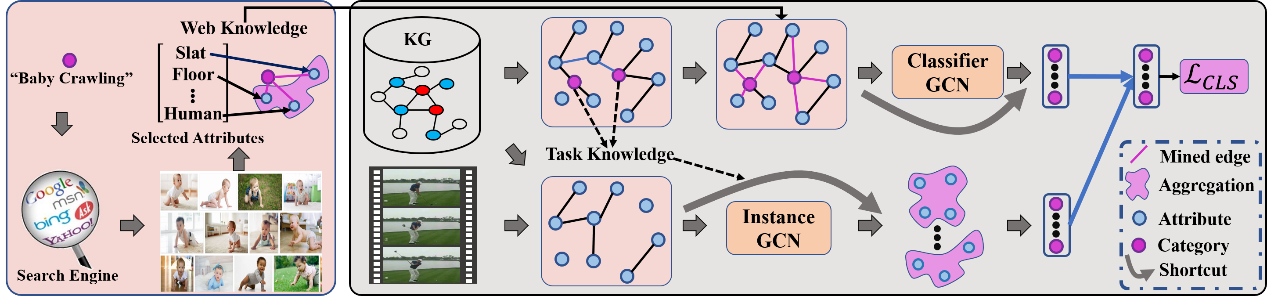

零样本视频分类旨在识别在模型训练过程中从未见过的视频类别,一般通过构建视觉特征和语义嵌入之间的映射来实现。研究表明通过挖掘视频包含的物体作为属性并结合外部知识能有效提升模型的性能。但是,从可见类别挖掘的物体属性不能有效泛化到未见类,且外部知识中属性之间的关系与视频中出现的属性关系存在较大偏差。对此,我们提出了基于网络知识的属性构建方法和属性-类别关系挖掘方法。如图1所示,根据视频类别名称在网络中搜集相关的图像,并应用预先训练的物体识别模型对收集的图像进行识别,提取频繁出现的物体作为该视频类别相关的属性,构建属性-类别关系。通过所挖掘的属性以及外部知识,采用图神经网络学习视觉特征到类别的映射,有效提升模型的泛化能力。此外,为解决现有方法过拟合到已见类别的问题,我们提出通过估计已见类和未知类之间的相似度来指导模型训练的方法。实验表明,所提方法取得了显著的性能提升。

图1 方法流程图

2. Concept Propagation via Attentional Knowledge Graph Reasoning for Video-Text Retrieval (Sheng Fang, Shuhui Wang, Junbao Zhuo, Qingming Huang, Bin MA, Xiaoming Wei, Xiaolin Wei)

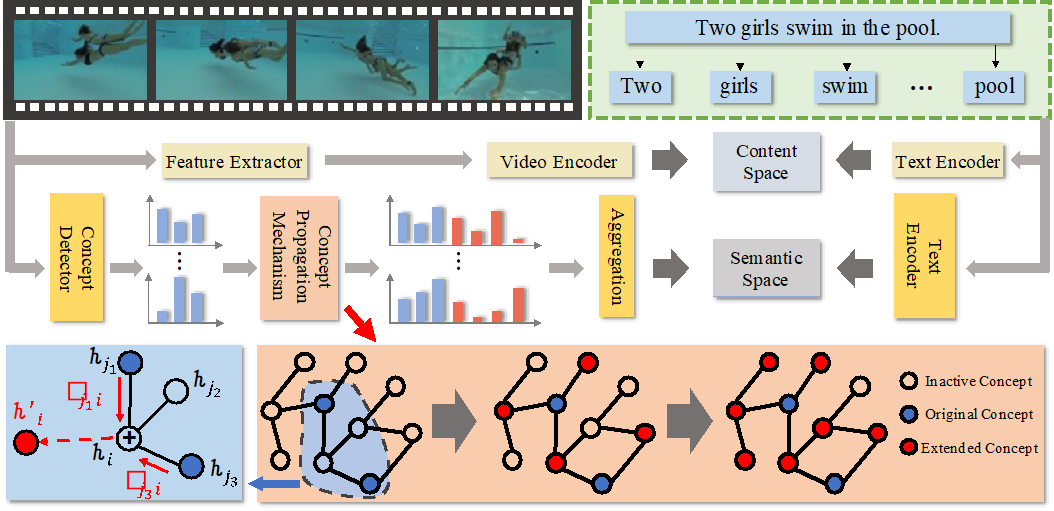

随着短视频平台的兴起,视频数量的急剧增长使得视频文本检索技术越发关键。这个任务的主要挑战在于如何找到视频和文本间细粒度的语义关联。为了解决这个问题,我们提出了一个基于注意力的概念传播网络框架(Attentional Concept Propagation, ACP),如图2所示。我们考虑了概念层级的信息,在内容层面的匹配的基础上引入了语义层面的匹配。在语义层面的匹配分支中,我们设计了概念传播机制来挖掘视频中的隐含语义。具体来说,在外部知识的指导下,我们利用概念间的关联,扩展得到检测器之外的概念,以此来丰富视频的表征。通过这种方式,我们的方法实现了细粒度的视频文本的匹配,从而得到更准确的检索结果。我们在多个不同的基准模型以及多个公开数据集上应用了我们的方法,均获得了稳定的性能提升,证明了我们方法的有效性和泛化性能。

图2 基于注意力的概念扩展网络框架

3. Synthesizing Counterfactual Samples for Effective Image-Text Matching (Hao Wei, Shuhui Wang, Xinzhe Han, Zhe Xue, Bin Ma, Xiaoming Wei, Xiaolin Wei)

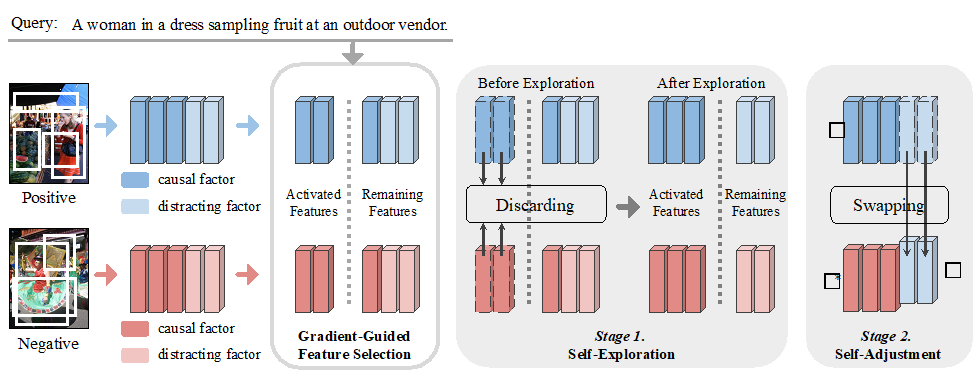

图像文本匹配(Image-Text Matching)是跨模态领域的一个基础研究问题,旨在度量图像和文本之间的语义相似性。最近的工作通常使用难负样本挖掘(Hard Negative Mining)来捕获图像和文本之间的多重对应关系。不幸的是,拥有丰富信息的负样本在训练数据中非常稀少,很难在随机采样的小批次中获得。受到因果推理的启发,我们通过类比难负样本挖掘和因果效应优化来解决这一问题。本文提出了反事实匹配(Counterfactual Matching,CFM)方法,用于更加有效的匹配关系挖掘。如图3所示,CFM包含三个主要部分,即用于自动因果因子识别的特征选择、用于保障因果因子完整性的自我探索和用于反事实样本合成的自我调整。与传统的难负样本挖掘相比,该方法缓解了过拟合现象,有效地捕获了图像和文本之间的细粒度匹配关联。本文将CFM与三种最先进的图像文本匹配模型结合起来进行评估。在两个公开数据集上进行的实验表明,本文提出的方法具有很强的通用性和有效性。

图3 本文所提出框架的示意图。从左到右三个模块分别代表梯度指导的特征选择、自我探索和自我调整。

附件: