2022年5月19日,实验室四篇论文被SIGKDD2022接收。SIGKDD会议的全称是“ACM SIGKDD Conference on Knowledge Discovery and Data Mining”,是数据挖掘领域的CCF-A类国际会议,今年是该会议第28届。四篇论文的信息概要如下:

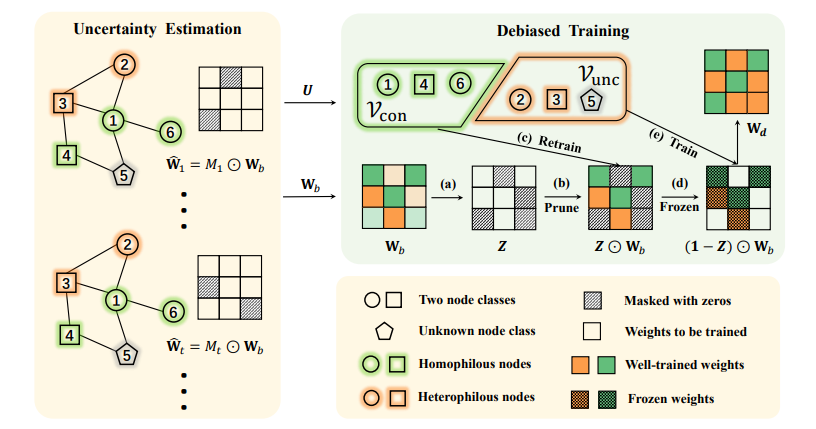

1. UD-GNN: Uncertainty-aware Debiased Training on Semi-Homophilous Graphs (Yang Liu, Xiang Ao, Fuli Feng, and Qing He) (Research Track)

图的同质偏好假设指出,图神经网络(GNN)在同质偏好图(连边节点标签相同)上表现良好,但不能很好地推广到异质偏好图(连边节点标签不同)中。已有的同质偏好或异质偏好的概念是对整个图的全局度量,很难描述节点的局部性质。从节点级的角度来看,作者发现现实世界的图结构多表现为同质偏好和异质偏好的混合,即同质偏好节点和异质偏好节点同时存在。在这种混合下,作者发现GNN严重偏向于同质偏好节点,在异质偏好节点上的性能急剧下降。为了缓解上述偏差问题,作者提出了不确定性感知的去偏图神经网络(UD-GNN)框架,它保留了有偏模型在确定节点上的知识,并对具有高度不确定性的节点进行补偿。UD-GNN通过估计GNN输出的不确定性识别异质偏好节点,然后通过修剪带有特定节点的有偏参数和细化具有高不确定性节点上的自由权值来训练去偏GNN。在合成数据集和多个基准数据集上的实验表明,UD-GNN模型表现更好,有效地缩小了同质偏好节点和异质偏好节点之间的性能差距。

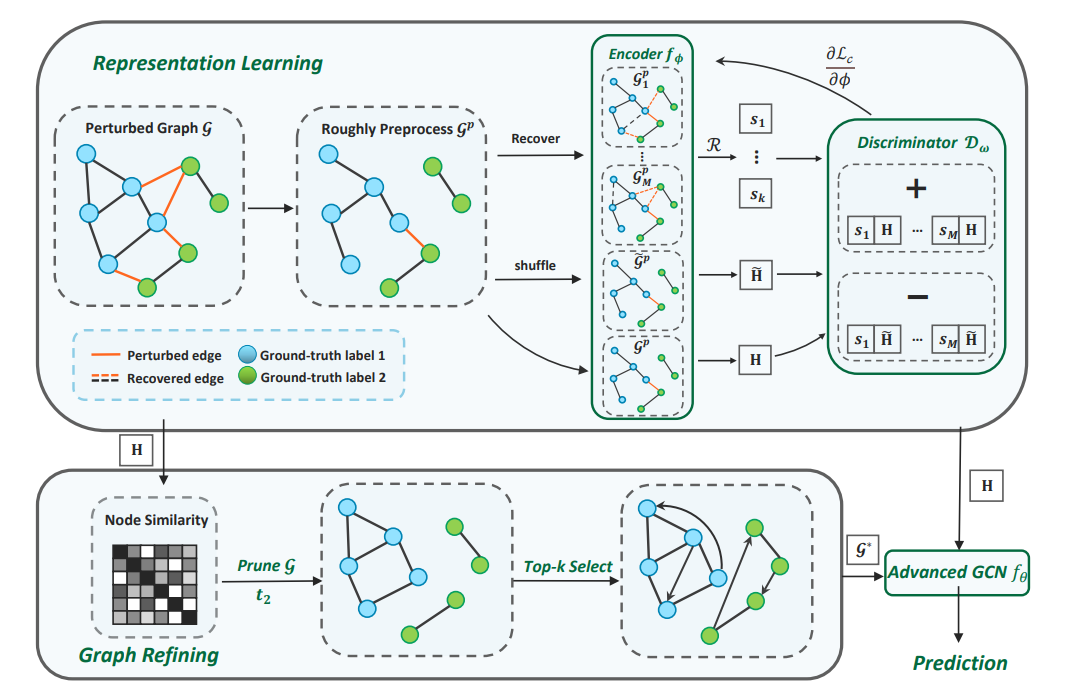

2. Reliable Representations Make A Stronger Defender: Unsupervised Structure Refinement for Robust GNN (Kuan Li, Yang Liu, Xiang Ao, Jianfeng Chi, Jinghua Feng, Hao Yang, and Qing He) (Research Track)

得益于消息传递机制,图神经网络在许多任务上取得了巨大成功,尤其是半监督的节点分类任务。但许多研究表明,图神经网络对结构扰动的反应极其明显,攻击者可以通过恶意篡改图结构大大降低分类性能。对于这种结构脆弱性,一种直接的思路就是优化被篡改的结构,以往的方法往往通过原始特征或者端到端学到的表征来进行结构学习,但二者都存在一定的问题。基于特征的方法忽略了图中的结构信息,从而导致信息维度缺失;而基于端到端特征学习的方法,由于分类器性能受损,特征学习的质量也随之降低,不能有效地优化结构。基于此,作者提出了STABLE,一套无监督图结构优化框架,通过面向鲁棒性的数据增强对比学习得到可靠无监督表征,再基于表征相似度进行结构优化得到用于下游任务的图结构。在下游分类器上,作者分析得出GCN的重归一化会加剧图神经网络的脆弱性。因此,作者提出了一个度敏感的传播机制,解决了原始GCN鲁棒性的问题。作者在四个公开数据集上进行了广泛的评估,验证了各种场景下STABLE都具有高鲁棒性。

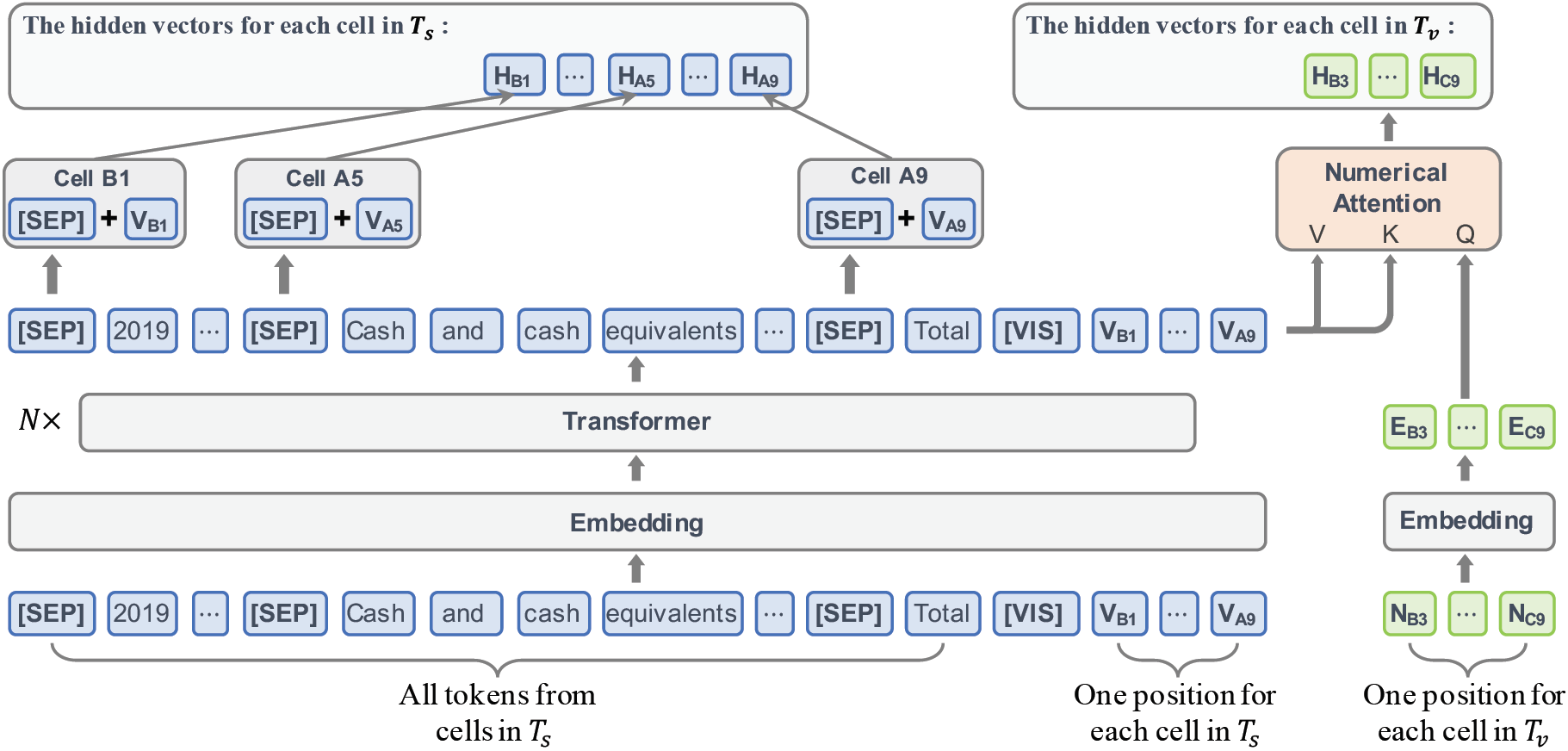

3. Numerical Tuple Extraction from Tables with Pre-training (Qingping Yang, Yixuan Cao, and Ping Luo) (Research Track)

表格在网络和各种垂直领域中无处不在,也存储了大量有价值的数据。然而,表格布局的巨大灵活性阻碍了对这些宝贵数据的智能理解。为了从表中解锁和利用这些知识,将数据提取为数值元组是一个关键步骤。在表格中提取数值元组需要深入了解单元格之间错综复杂的关联关系。这些关联关系隐含在表格的文本和视觉特征中,大致可以分为层级关系和并列关系。尽管许多研究在从表格中提取数据方面取得了相当的进展,但大多数研究只考虑了层级关系而忽视了并列关系。同时,已有研究也只在相对较小的语料库上评估他们的方法。作者提出了一个新的框架以从表格中提取数值元组,并在一个大规模测试集上对其进行评估。具体来说,作者将这项任务转换成单元格之间的关系提取问题。为了建模表格中具有复杂关联性的单元格,作者提出了一个基于BERT的预训练语言模型TableLM,以编码具有不同布局的表格。为了评估该框架,作者在一个包含19264个表格和60万个元组的大型金融数据集上进行了广泛的实验。

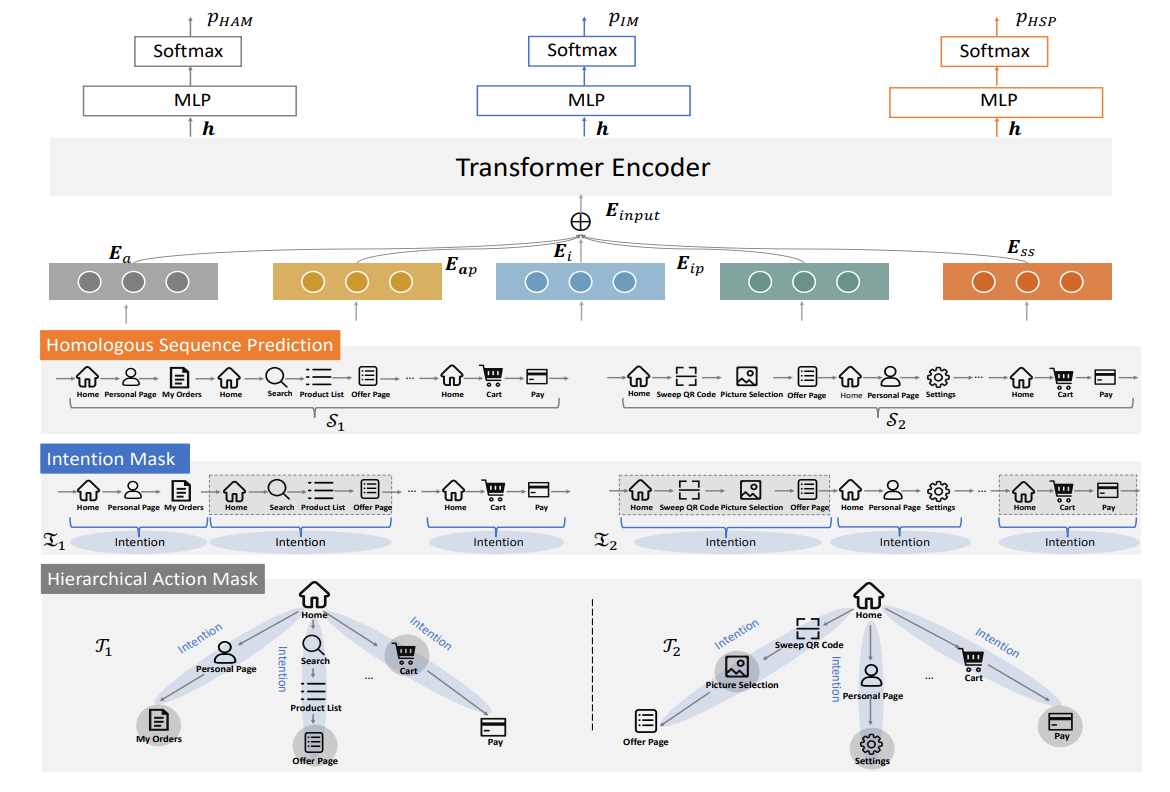

4. User Behavior Pre-training for Online Fraud Detection (Can Liu∗, Yuncong Gao∗, Li Sun, Jinghua Feng, Hao Yang, and Xiang Ao) (Applied Data Science Track)* indicates equal contribution.

COVID-19的爆发使线上平台的新兴服务迅速增长,同时也助长了各种各样的线上欺诈活动。由于技术和商业模式的创新,新兴服务的数量飞速增长,而标注数据的不足使现有的有监督和半监督欺诈检测模型对这些新兴服务可能失效。但是,网络平台在各类服务中不断积累了大量的无标注用户行为数据,这些数据可能有助于提高对新服务欺诈检测的性能。为此,作者提出可以对大规模无标注的用户行为序列进行预训练以支撑线上欺诈检测,其中用户行为序列由有序排列的用户行为组成。最近的研究表明,在行为序列中提取用户意图(由连续的用户行为组成)可以提高线上欺诈检测的性能。因此,作者设计了一个名为UB-PTM的模型,该模型通过三个不同粒度(行为、意图和序列粒度)的代理任务从大规模无标注数据中学习有关欺诈行为的知识。作者在交易级别和用户级别的三个线上欺诈检测下游任务上进行了广泛实验,结果表明UB-PTM更好地帮助了下游任务的性能提升。

附件: