2022年9月,实验室4篇论文被NeurIPS 2022接收。NeurIPS 2022的全称是Thirty-sixth Conference on Neural Information Processing Systems,是人工智能领域的顶级会议之一。NeurIPS 2022将于2022年11月28日-12月9日在美国新奥尔良举行。被录用论文的简要介绍如下:

1. Optimal Positive Generation via Latent Transformation for Contrastive Learning (Yinqi Li, Hong Chang, Bingpeng Ma, Shiguang Shan, Xilin Chen)

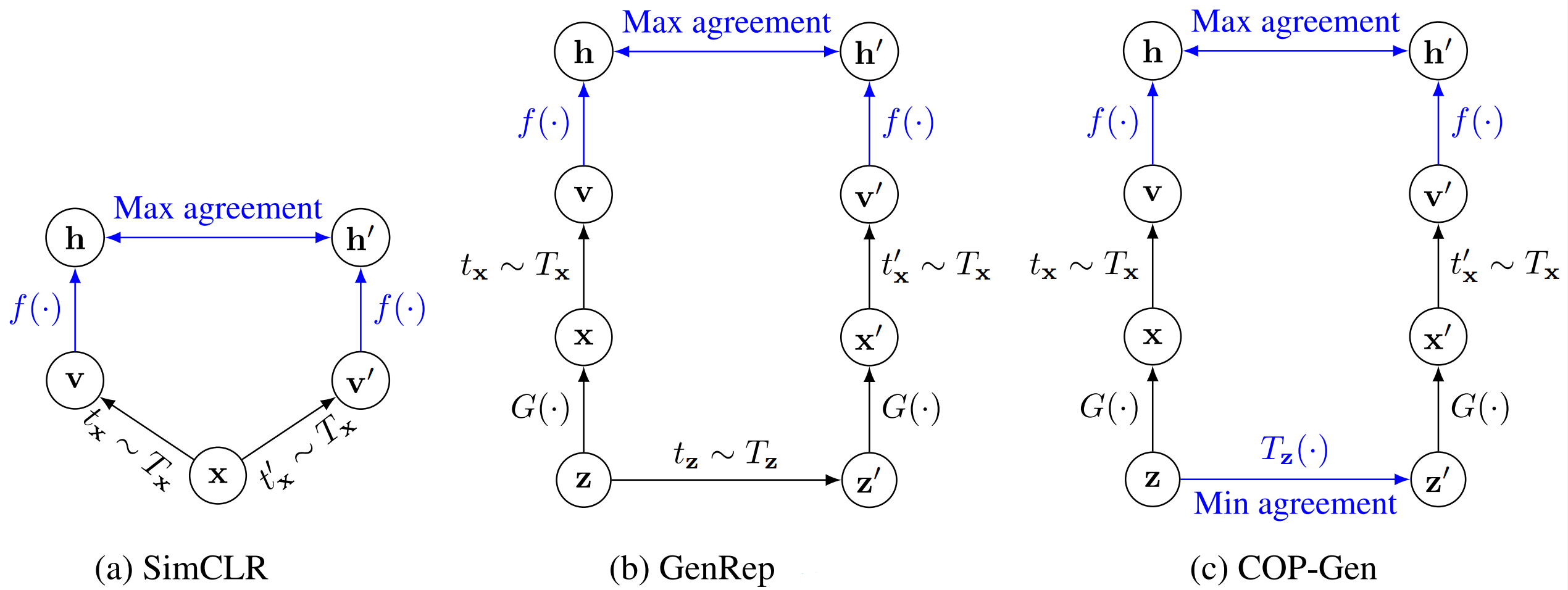

通过对比正负样本对进行学习的对比学习已成为自监督视觉表征学习领域的主流方法。现有工作在通过数据增强设计合适正样本对方面已经做出了巨大努力(图 1.a),但如何为每个示例构建最优的正样本仍然是一个悬而未决的问题。受预训练生成模型其隐空间中语义一致性和计算代价低的启发,本文提出一种学习示例特定的隐空间变换以生成自监督对比学习最优正样本的方法(COP-Gen,图 1.c)。具体来说,COP-Gen 被描述为一个隐空间中示例特定的导航器,它在语义一致性的约束条件下最小化生成的正样本对之间的互信息。理论分析表明,学到的隐空间变换可以为对比学习构建最优的正样本对,在保留语义的同时去除了尽可能多的无关信息。实验表明,使用 COP-Gen 生成的正样本对在自监督对比学习中始终优于其他隐空间变换方法(图 1.b),甚至超过了基于真实图像的方法。

图 1对比学习正样本构建方式对比

2. Exploring the Algorithm-Dependent Generalization of AUPRC Optimization with List Stability (Peisong Wen, Qianqian Xu, Zhiyong Yang, Yuan He, Qingming Huang)

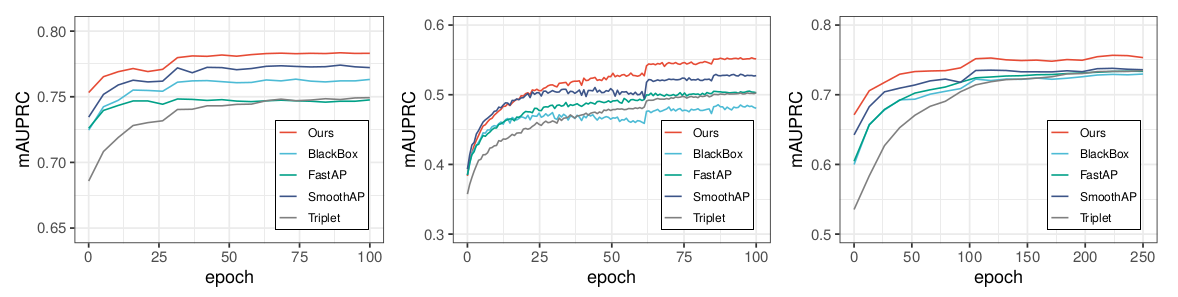

精度-召回率曲线下面积(Area Under the Precision-Recall Curve, AUPRC)广泛应用于长尾分类、排序等机器学习任务中。尽管AUPRC优化已被应用于图像检索、目标检测等任务中,其泛化性仍有待研究。为此,本文考虑设计AUPRC随机优化算法,使其具有良好的算法相关泛化性能。AUPRC的算法泛化性研究存在三大挑战:(a) 现有AUPRC优化算法中AUPRC随机估计在采样率与样本先验不一致时有偏;(b) AUPRC优化目标不可分解为逐样本损失之和,传统基于算法稳定性的泛化分析不可行;(c) AUPRC优化属于复合优化问题,需迭代更新辅助变量和模型参数,稳定性分析复杂度大。为了克服挑战(a),本文基于AUPRC重构提出了一种采样率无关的渐进无偏AUPRC估计。为了解决挑战(b),本文首次提出了逐列表算法稳定性,给出逐列表算法稳定性与泛化性关联,克服AUPRC不可分解问题;面对挑战(c),进一步基于转移矩阵的谱分解提出复合优化问题的逐列表稳定性分析方法,给出了所提出算法的收敛性和泛化性。在三个图像检索数据集上的实验表明,本文所提出的方法能有效提升模型的AUPRC性能,且实验结果与理论分析结论一致。

图 2在三个图像检索数据集上的AUPRC测试性能收敛曲线对比

3. Asymptotically Unbiased Instance-wise Regularized Partial AUC Optimization: Theory and Algorithm (Huiyang Shao, Qianqian Xu, Zhiyong Yang, Shilong Bao, Qingming Huang)

相比于传统的不平衡数据分类问题,医学诊断、垃圾邮件过滤以及风险金融账户检测等问题的应用场景中,往往更倾向于训练模型在较低的假阳率(False Positive Rate,FPR)区间内获得更高的真阳率(True Positive Rate,TPR),换句话说,这些应用场景更加关注于难样本的学习,而目前常用的AUC(Area Under the ROC Curve)指标更关注于整体的表现,与现有需求不一致。因此,本文考虑优化模型在较低假阳率区间内的单路偏AUC指标,称为OPAUC和较低假阳率和较高真阳率区间内的双路偏AUC指标,称为TPAUC。 优化偏AUC指标主要存下以下的难点:(a) 目标函数中存在分位数函数,并且该函数不可导,无法直接使用端到端的方式优化偏AUC指标;(b) 现有的关于偏AUC指标优化基本采用逐对的损失函数,不适应端到端的方式。为了解决以上问题,本文提出一种逐样本的minimax深度学习框架(Asymptotically Unbiased Instance-wise Regularized Partial AUC Optimization)去优化偏AUC指标。首先,为了克服难点 (a),本文采用一种可微分的替代优化损失ATK loss (Average Top-k Loss),该损失在最优点处计算得到的结果与原始分位数函数一致。为了解决难点 (b),本文采用现有的一种逐样本的AUC优化等价形式,并结合ATK loss将原始优化框架推广到了偏AUC指标优化中。在九个基准数据集上的实验表明,本文所提出的方法能有效提升模型的偏AUC指标。

图 3本文所优化的偏AUC指标

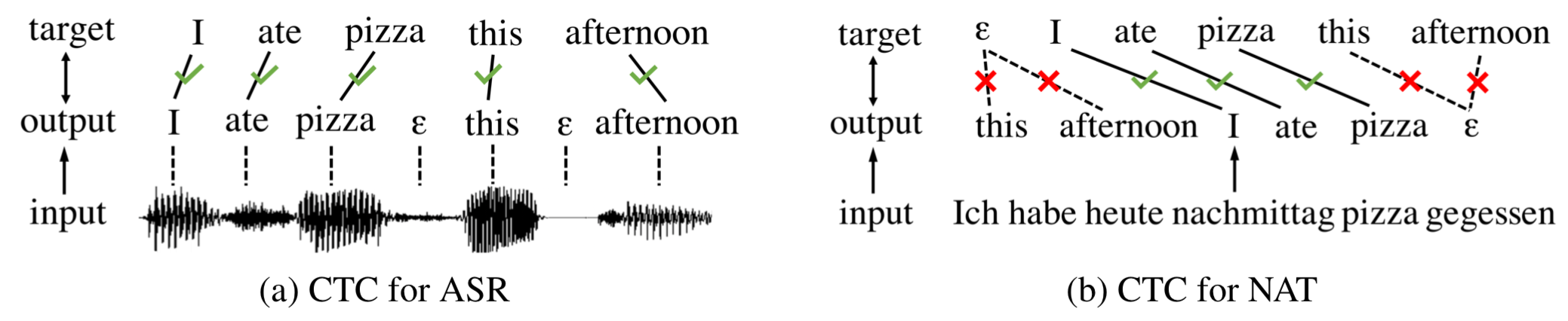

4. Non-Monotonic Latent Alignments for CTC-Based Non-Autoregressive Machine Translation (Chenze Shao, Yang Feng)

非自回归翻译模型能够并行生成整句译文,在解码速度上具有非常大的优势,但由于交叉熵损失无法正确地评估模型的输出,非自回归模型的性能与自回归模型有很大差距。基于CTC损失的非自回归模型能够建模参考译文与模型输出的隐式对齐,因此大幅提升了非自回归模型的性能水平,目前已成为非自回归机器翻译的主流模型之一。然而,CTC损失最早是为语音识别任务设计的,只能建模参考译文与模型输出间的单调对齐,无法处理机器翻译中普遍存在的非单调对齐现象(如图 4所示),这是非自回归机器翻译领域的一个open problem。在本文中,我们针对这个问题做了系统性的研究,将对齐空间扩展为非单调隐式对齐,并考虑所有与参考译文相关的对齐来计算损失。基于此,我们提出了基于二分图匹配和n元组匹配的两种解决方案,均能显著改善非自回归模型的翻译质量。在多个翻译数据集上,我们的最佳方法均达到了与自回归模型相当的性能,并保持着对自回归模型十倍以上的解码加速。

附件: