近日,实验室VIPL组关于食品图像识别和食材预测的研究工作“Ingredient-Guided Region Discovery and Relationship Modeling for Food Category-Ingredient Prediction” (作者: Wang Zhiling, Min Weiqing, Li Zhuo, Kang Liping, Wei Xiaoming, Wei Xiaolin, Jiang Shuqiang.) 被IEEE TIP 接收。IEEE TIP的全称为IEEE Transactions on Image Processing, 是计算机视觉和图像处理领域的主流国际期刊,当前影响因子为11.041。

1. Ingredient-Guided Region Discovery and Relationship Modeling for Food Category-Ingredient Prediction (Wang Zhiling, Min Weiqing, Li Zhuo, Kang Liping, Wei Xiaoming, Wei Xiaolin, Jiang Shuqiang)

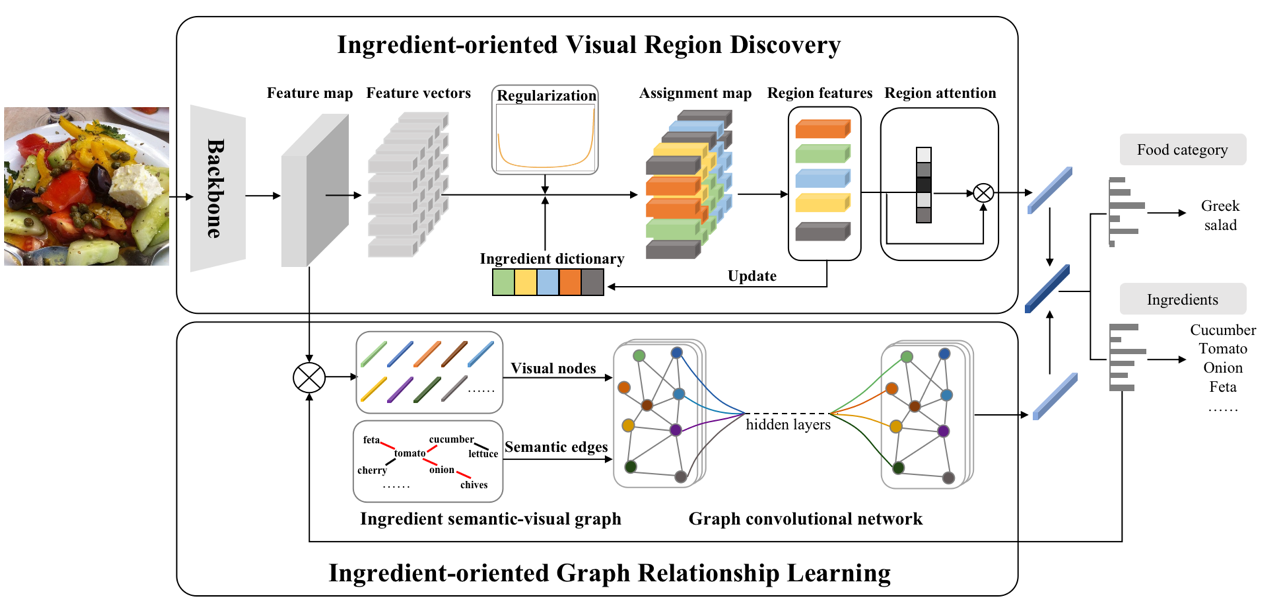

食品是由复杂多变的食材组成,挖掘食材视觉区域可以更好地帮助我们识别其类别。此外,食材间关系也很重要,如食材间的共现关系和互斥关系等。基于此,我们提出了多任务食品联合学习框架同时进行食品类别识别和食材预测。该框架主要由两部分组成,即食材视觉区域发现和食材图关系学习。针对食材视觉区域发现,我们提出通过预先构建好的食材字典将2D特征图分组为具体的食材区域。在此过程中,我们采用U形先验正则化食材的出现频率,进而提高食材发现能力。然后我们从食材分配图中池化得到相关的食材特征,并使用注意力机制对其加权。在食材图关系学习中,我们构建了面向食材的语义-视觉图来学习各种食材之间的关系。其中我们利用所有的食材视觉表征作为节点,并将所有食材的语义嵌入之间的相似度作为边,然后使用图卷积网络学习食材之间的各种关系。最后,对两个分支的输出,我们将它们融合在一起并将其送入分类器,通过多任务学习优化整个网络模型,同时进行食品类别识别和食材预测。最后,本方法在三个基准数据集(ETH Food-101、Vireo Food-172和ISIA Food-200)上进行评估,大量实验结果验证了我们所提方法的有效性。

图1 多任务食品类别-食材联合学习框架

附件: